ในยุคที่ AI กำลังเข้ามามีบทบาทสำคัญในชีวิตประจำวันของเรามากขึ้น การออกแบบระบบ AI ให้สามารถทำงานได้อย่างชาญฉลาดและมีประสิทธิภาพจึงเป็นเรื่องที่สำคัญมาก หนึ่งในแนวคิดที่น่าสนใจคือ “Agentic Design Patterns” หรือรูปแบบการออกแบบที่ช่วยให้ระบบ AI สามารถคิด ตัดสินใจ และทำงานได้อย่างอิสระ มาทำความรู้จักกับแนวคิดนี้กันให้ลึกซึ้งยิ่งขึ้น

Agentic Design Patterns คืออะไร?

Agentic Design Patterns เป็นแนวทางการออกแบบที่ใช้ในการสร้างระบบ AI ที่สามารถทำงานได้อย่างอิสระ (Autonomous) โดยไม่ต้องพึ่งพาการควบคุมจากมนุษย์ตลอดเวลา รูปแบบการออกแบบเหล่านี้ช่วยกำหนดวิธีการที่ระบบ AI จะคิด ตัดสินใจ และมีปฏิสัมพันธ์กับสภาพแวดล้อม รวมถึงระบบอื่นๆ เพื่อให้บรรลุเป้าหมายที่ต้องการ

รูปแบบการออกแบบที่น่าสนใจ

1. ReACT - การผสมผสานระหว่างการคิดและการกระทำ

ReACT (Reasoning and Acting) เป็นรูปแบบที่น่าสนใจมาก เพราะจำลองการทำงานคล้ายกับวิธีที่มนุษย์เราคิดและตัดสินใจ โดยระบบจะ:

- วิเคราะห์สถานการณ์และคิดหาทางแก้ไข

- ลงมือทำตามแผนที่วางไว้

- ประเมินผลลัพธ์และปรับปรุงการตัดสินใจในรอบถัดไป

ตัวอย่างที่เห็นได้ชัดคือ ระบบวางแผนการเดินทาง ที่จะสลับไปมาระหว่างการค้นหาเที่ยวบิน (การคิด) และการจองตั๋ว (การกระทำ) โดยปรับเปลี่ยนแผนตามราคาและความพร้อมของเที่ยวบินที่พบ

2. ระบบที่พัฒนาตัวเองได้ (Self-Improvement)

ความน่าสนใจของรูปแบบนี้อยู่ที่ความสามารถในการเรียนรู้และพัฒนาตัวเองอย่างต่อเนื่อง เหมือนกับที่มนุษย์เราเรียนรู้จากประสบการณ์ ระบบจะ:

- ประเมินผลการทำงานของตัวเอง

- เรียนรู้จากข้อมูลใหม่ๆ

- ปรับปรุงกระบวนการทำงานภายใน

ตัวอย่างที่เห็นได้บ่อยคือ ผู้ช่วยเขียนโค้ด ที่จะปรับปรุงคำแนะนำให้ดีขึ้นจากการวิเคราะห์ผลตอบรับของผู้ใช้

3. Agentic RAG - การผสมผสานการค้นหาและการสร้างเนื้อหา

รูปแบบนี้น่าสนใจเพราะช่วยให้ระบบ AI สามารถใช้ข้อมูลจากแหล่งภายนอกมาประกอบการตัดสินใจได้ โดย:

- ค้นหาข้อมูลที่เกี่ยวข้องจากฐานข้อมูล

- นำข้อมูลมาประมวลผลและสร้างเป็นคำตอบ

- ตรวจสอบความถูกต้องของข้อมูลก่อนนำไปใช้

ระบบแชทบอทให้บริการลูกค้าที่สามารถค้นหาข้อมูลจากเอกสารนโยบายและสร้างคำตอบที่เหมาะสมเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

4. Meta-Agent - ผู้จัดการระบบอัจฉริยะ

เปรียบเสมือนผู้จัดการโครงการที่คอยประสานงานระหว่างทีมย่อยต่างๆ Meta-Agent จะ:

- แบ่งงานให้ระบบย่อยที่เชี่ยวชาญเฉพาะด้าน

- ประสานงานให้ทุกส่วนทำงานสอดคล้องกัน

- ติดตามและควบคุมคุณภาพของงาน

ตัวอย่างเช่น ระบบบริหารโครงการที่แบ่งงานให้ระบบย่อยดูแลเรื่องการจัดตารางเวลา งบประมาณ และการรายงานผล

5. ระบบวางแผนและปฏิบัติ (Planner-Executor)

รูปแบบนี้แยกการทำงานเป็นสองส่วนชัดเจน คือ:

ส่วนวางแผน:

- วิเคราะห์สถานการณ์

- กำหนดกลยุทธ์

- จัดลำดับความสำคัญของงาน

ส่วนปฏิบัติ:

- ดำเนินการตามแผน

- รายงานความคืบหน้า

- แจ้งเตือนเมื่อพบปัญหา

ระบบ AI ที่เล่นเกมเป็นตัวอย่างที่ดี โดยส่วนวางแผนจะคิดกลยุทธ์การเล่น และส่วนปฏิบัติจะควบคุมการเคลื่อนไหวในเกม

6. Reflexive Agent - ระบบตอบสนองอัตโนมัติ

รูปแบบนี้เน้นการตอบสนองที่รวดเร็วต่อการเปลี่ยนแปลง โดย:

- ตรวจจับการเปลี่ยนแปลงในสภาพแวดล้อม

- ตอบสนองทันทีตามกฎที่กำหนดไว้

- ไม่ต้องใช้เวลาคิดวิเคราะห์มาก

หุ่นยนต์ดูดฝุ่นที่หลบสิ่งกีดขวางอัตโนมัติเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

7. Interactive Learning - การเรียนรู้แบบมีปฏิสัมพันธ์

รูปแบบนี้น่าสนใจเพราะช่วยให้ระบบพัฒนาได้จากการมีปฏิสัมพันธ์กับผู้ใช้ โดย:

- รับข้อเสนอแนะจากผู้ใช้

- วิเคราะห์และเรียนรู้จากข้อมูลป้อนกลับ

- ปรับปรุงพฤติกรรมให้ตรงกับความต้องการ

ระบบแปลภาษาที่เรียนรู้จากการแก้ไขของผู้ใช้เป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

8. การแยกงานเป็นลำดับชั้น (Hierarchical Task Decomposition)

รูปแบบนี้ช่วยจัดการงานที่ซับซ้อนได้อย่างมีประสิทธิภาพ โดย:

- แยกงานใหญ่เป็นงานย่อยที่จัดการได้ง่ายขึ้น

- จัดลำดับความสำคัญของงานย่อย

- ติดตามความคืบหน้าในแต่ละระดับ

ผู้ช่วย AI ที่ช่วยจัดงานอีเวนต์ โดยแบ่งเป็นการจองสถานที่ ส่งการ์ดเชิญ และจัดตารางงาน เป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

9. ระบบที่ทำงานตามเป้าหมาย (Goal-Oriented Agent)

รูปแบบนี้เน้นการทำงานที่มีจุดมุ่งหมายชัดเจน โดย:

- กำหนดเป้าหมายที่ต้องการ

- วางแผนการทำงานเพื่อให้บรรลุเป้าหมาย

- ปรับเปลี่ยนกลยุทธ์ตามสถานการณ์

ระบบวางแผนการเงินที่ปรับกลยุทธ์การลงทุนเพื่อให้บรรลุเป้าหมายการออมเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

10. ระบบจดจำบริบท (Contextual Memory)

รูปแบบนี้ช่วยให้ระบบสามารถจดจำและใช้ประโยชน์จากข้อมูลในอดีต โดย:

- เก็บข้อมูลการโต้ตอบกับผู้ใช้

- วิเคราะห์รูปแบบการใช้งาน

- ปรับการทำงานให้เหมาะกับแต่ละผู้ใช้

ระบบแชทบอทที่จำความชอบของผู้ใช้และปรับการสนทนาให้เหมาะสมเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

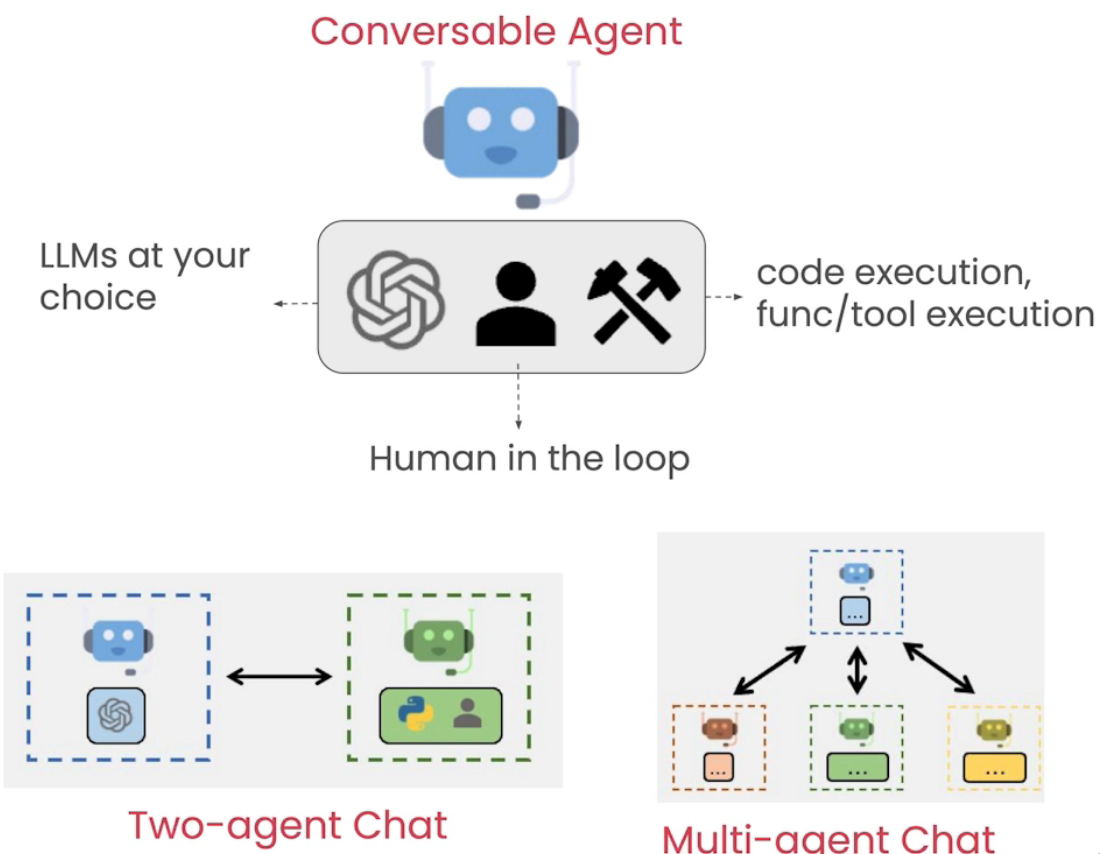

11. ระบบหลายตัวแทนที่ทำงานร่วมกัน (Collaborative Multi-Agent Systems)

รูปแบบนี้น่าสนใจเพราะช่วยให้ระบบย่อยหลายๆ ระบบทำงานร่วมกันได้อย่างมีประสิทธิภาพ โดย:

- แบ่งงานตามความเชี่ยวชาญ

- ประสานงานระหว่างระบบย่อย

- แก้ไขความขัดแย้งที่อาจเกิดขึ้น

โดรนขนส่งที่ทำงานประสานกันเพื่อส่งพัสดุในเมืองเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

12. ระบบสำรวจ (Exploratory Agent)

รูปแบบนี้เหมาะกับการค้นหาข้อมูลและโอกาสใหม่ๆ โดย:

- สำรวจสภาพแวดล้อมหรือข้อมูลที่ไม่คุ้นเคย

- วิเคราะห์และจัดเก็บข้อมูลที่พบ

- ระบุรูปแบบหรือโอกาสที่น่าสนใจ

ผู้ช่วยวิจัยที่สแกนวารสารวิชาการเพื่อค้นหาแนวโน้มใหม่ๆ เป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

ตัวอย่าง Exploratory Agent

from typing import Dict, List, TypedDict, Optional from datetime import datetime import json from dataclasses import dataclass, asdict from langgraph.graph import StateGraph, END from langchain_core.messages import HumanMessage, AIMessage from langchain_community.chat_models import ChatOpenAI from collections import defaultdict import os # Define data structures @dataclass class ResearchPaper: title: str authors: List[str] abstract: str keywords: List[str] publication_date: str journal: str citations: int research_areas: List[str] @dataclass class ResearchTrend: topic: str emerging_keywords: List[str] key_papers: List[str] growth_rate: float # Trend growth rate relevance_score: float # 0-1 first_observed: str last_updated: str @dataclass class Insight: trend_id: str description: str supporting_evidence: List[str] potential_impact: str confidence_score: float timestamp: str class ResearchState(TypedDict): messages: List[str] papers: Dict[str, Dict] identified_trends: Dict[str, Dict] insights: List[Dict] research_focus: List[str] analysis_results: Optional[Dict] next_action: str # Initialize OpenRouter LLM llm = ChatOpenAI(model="gpt-4", temperature=0.7) class TrendAnalyzer: """Analyzes research papers to identify trends""" @staticmethod def identify_trends(papers: List[ResearchPaper]) -> List[ResearchTrend]: # Group papers by research areas area_papers = defaultdict(list) for paper in papers: for area in paper.research_areas: area_papers[area].append(paper) messages = [ HumanMessage(content=f""" Analyze these research papers and identify emerging trends: Papers by Research Area: {json.dumps({area: [asdict(p) for p in papers] for area, papers in area_papers.items()}, indent=2)} For each trend, identify: 1. Core topic and theme 2. Key emerging keywords 3. Most influential papers 4. Growth trajectory 5. Potential impact Focus on: - Novel research directions - Emerging methodologies - Cross-disciplinary connections - Technology applications """) ] response = llm.invoke(messages) # Process trends (simplified - would parse LLM response in real implementation) trends = [] for area, area_paper_list in area_papers.items(): if len(area_paper_list) >= 3: # Minimum papers to identify trend recent_papers = sorted( area_paper_list, key=lambda p: p.publication_date, reverse=True )[:3] trend = ResearchTrend( topic=area, emerging_keywords=list(set( kw for p in recent_papers for kw in p.keywords )), key_papers=[p.title for p in recent_papers], growth_rate=0.5, # Would calculate from citation patterns relevance_score=0.8, # Would calculate based on analysis first_observed=min(p.publication_date for p in area_paper_list), last_updated=max(p.publication_date for p in area_paper_list) ) trends.append(trend) return trends class InsightGenerator: """Generates insights from identified trends""" @staticmethod def generate_insights( trends: List[ResearchTrend], papers: Dict[str, ResearchPaper] ) -> List[Insight]: messages = [ HumanMessage(content=f""" Generate research insights based on these trends: Research Trends: {json.dumps([asdict(t) for t in trends], indent=2)} Supporting Papers: {json.dumps({k: asdict(v) for k, v in papers.items()}, indent=2)} For each insight: 1. Describe the key finding 2. Provide supporting evidence 3. Assess potential impact 4. Estimate confidence level Consider: - Cross-trend patterns - Unexpected connections - Research gaps - Future implications """) ] response = llm.invoke(messages) # Generate insights (simplified) insights = [] for trend in trends: insight = Insight( trend_id=trend.topic, description=f"Emerging trend in {trend.topic}", supporting_evidence=trend.key_papers, potential_impact="HIGH" if trend.growth_rate > 0.7 else "MEDIUM", confidence_score=trend.relevance_score, timestamp=datetime.now().isoformat() ) insights.append(insight) return insights class PatternMatcher: """Identifies patterns and connections across research areas""" @staticmethod def find_patterns( trends: List[ResearchTrend], insights: List[Insight] ) -> Dict: messages = [ HumanMessage(content=f""" Identify patterns and connections across research trends: Trends: {json.dumps([asdict(t) for t in trends], indent=2)} Insights: {json.dumps([asdict(i) for i in insights], indent=2)} Look for: 1. Common themes across areas 2. Complementary research directions 3. Technology convergence 4. Methodology patterns Highlight: - Strong connections - Research opportunities - Potential collaborations """) ] response = llm.invoke(messages) # Analyze patterns (simplified) patterns = { "theme_clusters": defaultdict(list), "methodology_patterns": [], "research_opportunities": [] } # Group related trends for trend in trends: for keyword in trend.emerging_keywords: patterns["theme_clusters"][keyword].append(trend.topic) return patterns def analyze_trends(state: ResearchState) -> ResearchState: """ Identify and analyze research trends """ # Convert papers to objects papers = [ ResearchPaper(**paper_data) for paper_data in state["papers"].values() ] # Identify trends analyzer = TrendAnalyzer() trends = analyzer.identify_trends(papers) # Store trends state["identified_trends"] = { trend.topic: asdict(trend) for trend in trends } state["next_action"] = "GENERATE_INSIGHTS" return state def generate_insights(state: ResearchState) -> ResearchState: """ Generate insights from identified trends """ # Convert data structures trends = [ ResearchTrend(**trend_data) for trend_data in state["identified_trends"].values() ] papers = { k: ResearchPaper(**v) for k, v in state["papers"].items() } # Generate insights generator = InsightGenerator() insights = generator.generate_insights(trends, papers) # Find patterns matcher = PatternMatcher() patterns = matcher.find_patterns(trends, insights) # Update state state["insights"] = [asdict(insight) for insight in insights] state["analysis_results"] = patterns state["next_action"] = "END" return state def router(state: ResearchState) -> str: """Route to the next step based on the current state""" return state["next_action"] # Create the graph workflow = StateGraph(ResearchState) # Add nodes workflow.add_node("analyze", analyze_trends) workflow.add_node("insights", generate_insights) # Add edges workflow.add_edge("analyze", router) workflow.add_edge("insights", router) # Set entry point workflow.set_entry_point("analyze") # Create conditional edges workflow.add_conditional_edges( "analyze", router, { "GENERATE_INSIGHTS": "insights", "END": END } ) workflow.add_conditional_edges( "insights", router, { "END": END } ) # Example usage if __name__ == "__main__": # Initialize state with example papers initial_state = { "messages": [], "papers": { "paper1": { "title": "Deep Learning in Medical Imaging", "authors": ["Smith, J.", "Jones, K."], "abstract": "This paper explores applications of deep learning...", "keywords": ["deep learning", "medical imaging", "AI"], "publication_date": "2024-01-15", "journal": "AI in Medicine", "citations": 10, "research_areas": ["AI", "Healthcare"] }, "paper2": { "title": "Advances in Quantum Computing", "authors": ["Brown, R.", "Lee, M."], "abstract": "Recent developments in quantum computing...", "keywords": ["quantum computing", "qubits", "algorithms"], "publication_date": "2024-01-20", "journal": "Quantum Computing Review", "citations": 15, "research_areas": ["Quantum Computing", "Computer Science"] } }, "identified_trends": {}, "insights": [], "research_focus": ["AI", "Quantum Computing", "Healthcare"], "analysis_results": None, "next_action": "ANALYZE" } # Run the workflow app = workflow.compile() for output in app.stream(initial_state): print("\nStep Output:") print(json.dumps(output, indent=2))

13. ระบบจัดการขั้นตอนการทำงานแบบปรับตัวได้ (Adaptive Workflow Orchestration)

รูปแบบนี้ช่วยให้ระบบปรับเปลี่ยนการทำงานตามสถานการณ์ได้อย่างยืดหยุ่น โดย:

- ติดตามการเปลี่ยนแปลงของสภาพแวดล้อม

- ปรับลำดับความสำคัญของงาน

- จัดสรรทรัพยากรใหม่ตามความจำเป็น

ระบบบริหารจัดการโรงพยาบาลที่ปรับการจัดสรรทรัพยากรตามจำนวนผู้ป่วยที่เข้ามาเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

14. ระบบซ่อมแซมตัวเอง (Self-Healing Systems)

รูปแบบนี้น่าสนใจเพราะช่วยให้ระบบสามารถรักษาเสถียรภาพการทำงานได้ด้วยตัวเอง โดย:

- ตรวจจับปัญหาหรือข้อผิดพลาด

- วิเคราะห์สาเหตุของปัญหา

- ดำเนินการแก้ไขโดยอัตโนมัติ

ระบบจัดการคลาวด์ที่สามารถตรวจจับและแก้ไขปัญหาเซิร์ฟเวอร์ที่ทำงานผิดปกติเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

15. ระบบตัดสินใจตามหลักจริยธรรม (Ethical Decision-Making)

รูปแบบนี้มีความสำคัญมากในยุคที่ AI มีบทบาทในการตัดสินใจที่ส่งผลกระทบต่อชีวิตมนุษย์ โดย:

- พิจารณาผลกระทบทางจริยธรรม

- ชั่งน้ำหนักระหว่างประโยชน์และความเสี่ยง

- ตัดสินใจบนพื้นฐานของค่านิยมและบรรทัดฐานของสังคม

รถยนต์ไร้คนขับที่ต้องตัดสินใจในสถานการณ์ฉุกเฉินโดยคำนึงถึงความปลอดภัยของทุกฝ่ายเป็นตัวอย่างที่ดีของการใช้งานรูปแบบนี้

การนำ Agentic Design Patterns ไปใช้งาน

การเลือกใช้รูปแบบการออกแบบที่เหมาะสมเป็นสิ่งสำคัญมาก เพราะแต่ละรูปแบบมีจุดแข็งและข้อจำกัดที่แตกต่างกัน ในการพัฒนาระบบ AI ควรพิจารณาปัจจัยต่างๆ ดังนี้:

-

ลักษณะของงาน: งานที่ต้องการการตอบสนองรวดเร็วอาจเหมาะกับ Reflexive Agent ในขณะที่งานที่ซับซ้อนอาจต้องใช้ Meta-Agent หรือ Collaborative Multi-Agent Systems

-

ทรัพยากรที่มี: บางรูปแบบต้องการทรัพยากรการประมวลผลมาก เช่น Self-Improvement หรือ Adaptive Workflow Orchestration ควรพิจารณาความพร้อมของระบบก่อนเลือกใช้

-

ความต้องการด้านความแม่นยำ: งานที่ต้องการความแม่นยำสูงอาจต้องใช้รูปแบบที่มีการตรวจสอบและยืนยันผลลัพธ์ เช่น ReACT หรือ Planner-Executor

-

ความต้องการด้านการปรับตัว: หากระบบต้องทำงานในสภาพแวดล้อมที่เปลี่ยนแปลงบ่อย ควรเลือกรูปแบบที่มีความยืดหยุ่นสูง เช่น Self-Improvement หรือ Interactive Learning

บทสรุป

Agentic Design Patterns เป็นแนวคิดที่น่าสนใจและมีประโยชน์มากในการพัฒนาระบบ AI ให้ทำงานได้อย่างชาญฉลาด การเข้าใจจุดแข็งและข้อจำกัดของแต่ละรูปแบบจะช่วยให้เราสามารถเลือกใช้และผสมผสานรูปแบบต่างๆ ได้อย่างเหมาะสม เพื่อสร้างระบบ AI ที่มีประสิทธิภาพและตอบโจทย์ความต้องการได้อย่างแท้จริง

แหล่งข้อมูลเพิ่มเติม

Cover image by AI Agentic Design Patterns with AutoGen

ปล. บทความนี้เขียนด้วย AI (^ . ^)